El avance de la tecnología abrió las puertas a diversas facilidades en la vida diaria de los seres humanos. A nivel mundial, el 56% de las empresas ha adoptado Inteligencia Artificial (IA) en al menos una función. Muchas de ellas están dedicadas a sostener conversaciones con los usuarios.

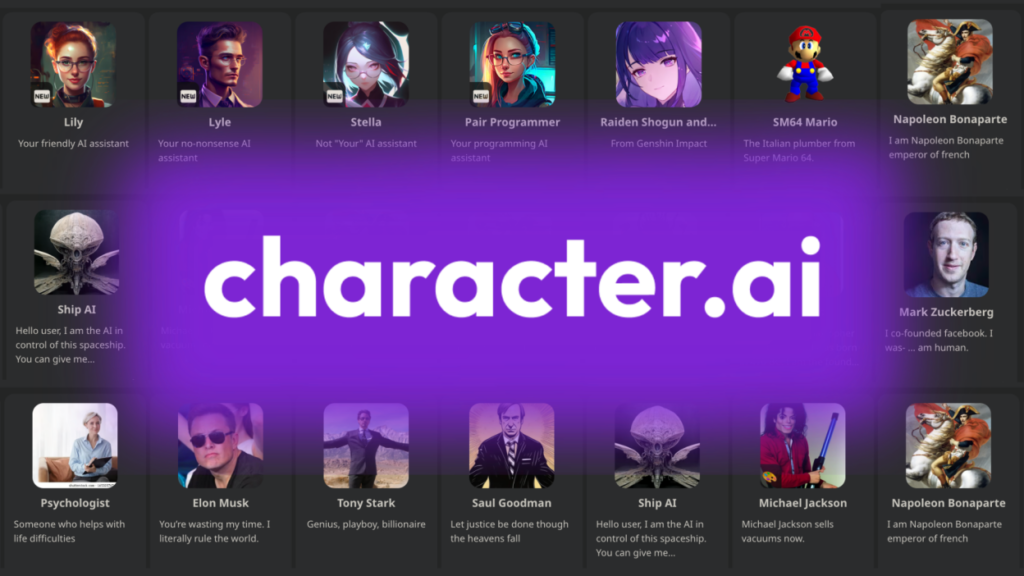

Una empresa que desarrolló un chatbot basado en modelos de lenguaje neuronal y que puede generar respuestas de texto parecidas a las de los seres humanos, es Character.ai.

Su servicio se puso a disposición del público en septiembre de 2022 y los usuarios pueden crear personajes y diseñar sus “personalidades”. Muchos personajes pueden estar basados en fuentes de medios ficticios o celebridades.

Algunos se crearon con ciertos objetivos en mente, como ayudar con la escritura creativa o ser un juego de aventuras basado en texto.

El suicidio de un joven

Sewell Setzer III, un usuario de 14 años mantuvo conversaciones con un chatbot de esta empresa y se enamoró perdidamente del “personaje” inspirado en Daenerys Targaryen, personaje de la famosa serie Game of Thrones. Su enamoramiento terminó en su trágica muerte en febrero de este 2024.

El joven Swell decidió quitarse la vida tras compartir con la IA, antes de su muerte, pensamientos suicidas.

Sin embargo y según la familia, Swell comenzó a deteriorarse mentalmente cuando descargó la aplicación en abril de 2023. También lo diagnosticaron con ansiedad, trastorno de desregulación del estado de ánimo y síndrome de Asperger leve, y recibió terapia en cinco ocasiones.

A pesar de ello, su estado mental no mejoró, y sus padres tomaron medidas, como retirarle el teléfono. El New York Times reportó que, días antes de su muerte, Sewell intentó reconectarse con el chatbot usando dispositivos de su madre, a pesar de que le habían retirado su propio teléfono.

La demanda

Megan Garcia, su madre, ha decidido demandar a la empresa Character.ai alegando que los chatbots de la compañía habrían mantenido interacciones abusivas y sexuales con su hijo, alentándolo a quitarse la vida.

La demanda, presentada ante el Tribunal de Distrito de Estados Unidos en Orlando, acusa a Character.AI de negligencia, muerte por negligencia y otros cargos, incluyendo la inflición intencional de angustia emocional.

La madre también alega que la IA no tomó ninguna medida para alertar a un adulto o a las autoridades cuando Sewell expresó pensamientos suicidas.

A pesar de que son muchos los filtros y cuidados que han puesto a las IA al rededor del mundo, se han analizado sus consecuencias y beneficios; ¿Se puede culpar a una Inteligencia Artificial por las decisiones de un ser humano?

1 comment

[…] poco Character.ai fue escenario del suicidio de un adolescente en Florida y la empresa aún sigue bajo demanda por la […]